多模态技术基础

多模态深度学习技术基础

多模态任务

图文跨模态检索

图像描述

视觉问答

文本生成图像

指称表达

文本表示

基于词嵌入的静态词表示

词嵌入是指使用模型将语料中的每个词映射为一个低维、稠密、连续的向量的技术

Word2Vec

Word2Vec指一类神经网络语言模型,其中又分为两种CBOW和Skip-gram

- 导入——语言模型

语言模型分为统计语言模型和神经网络语言模型

统计语言模型:n-gram模型

神经网络语言模型:NNLM模型

- CBOW和Skip-gram

CBOW:通过上下文来预测当前词

Skip-gram:用当前词来预测上下文

- Word2Vec和NNLM的区别

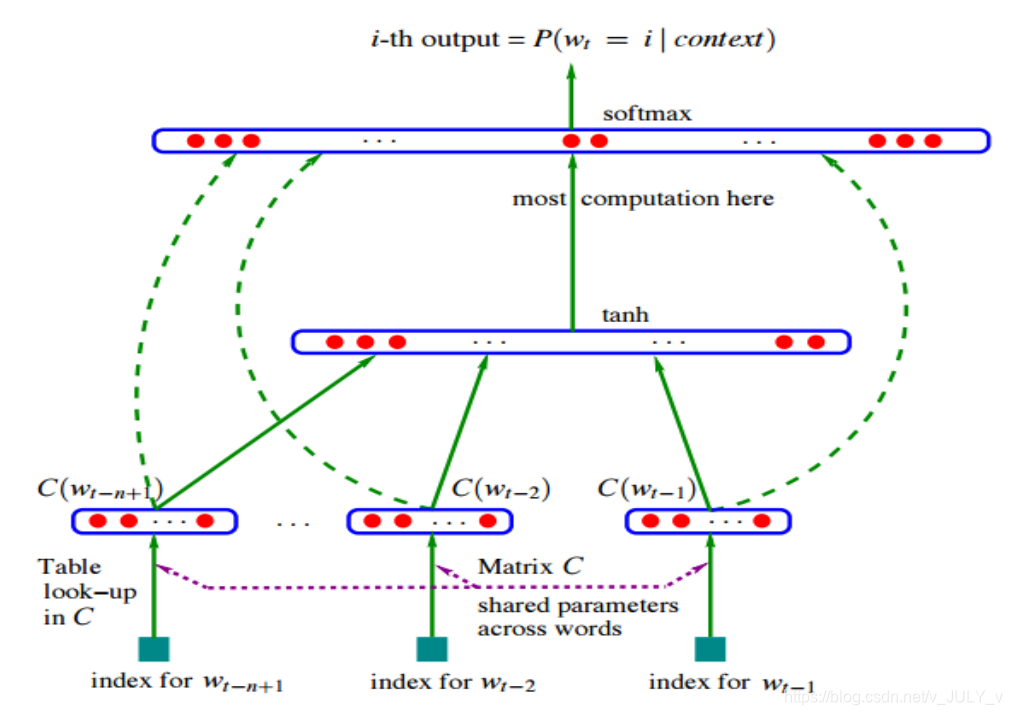

NNLM的模型结构:

对于语言模型,目的是想预测的更准确,而词向量矩阵知识一个副产品。

NNLM:重点是预测下一词,双层感知机$softmax(w_2(tanh(w_1 (xQ) +b_1))+b_2)$

Word2Vec:CBOW和Skip-gram的两种架构的重点都是得到一个$Q$矩阵,$softmax(w_1(xQ)+b_1)$

- Word2Vec的缺点

词向量不能表示多义—>ELMO

GloVe

基于循环神经网络的动态词表示

循环神经网络基础

现代循环神经网络

- 长短时记忆网络(LSTM)

- 门控循环单元(GRU)

- 双向循环神经网络(RNN)

- 深度循环神经网络

动态词表示和整体表示

基于注意力的预训练语言模型表示

自注意力

Transformer编码器

Bert

Bert词表示和整体表示

图像表示

基于卷积神经网络的整体表示和网格表示

卷积神经网络基础

现代卷积神经网络

整体表示和网格表示

基于目标检测模型的区域表示

基于深度学习的目标检测基础

区域表示

基于视觉Transformer的整体表示和块表示

使用注意力代替卷积

视觉Transformer

整体表示和块表示

基于自编码器的压缩表示

量化自编码器:VQ-VAE

量化生成对抗网络:VQGAN

变分生成对抗网络:KLGAN

参考丛书:多模态深度学习技术基础 冯方向、王小捷 著 清华大学出版社

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 SpongeBob's Blog!